Welche Rolle spielen User Interfaces damit die Ger?te einfacher zu bedienen sind?

P.Keppler: Das Mobiltelefon setzt da nat?rlich hohe Anforderungen, was die Bedienerfreundlichkeit angeht. Die Frage, die sich Hersteller stellen m?ssen: Schafft man es die komplexeren Funktionen eines Sensors in einfache Bedienoberfl?chen einzubinden? Insbesondere weil wir bei der Bildverarbeitung am Ende immer noch mit der Physik unterwegs sind und uns auch um physikalische Effekte auf der optischen Seite Gedanken machen m?ssen.

M.Gonschior: Die Usability ist der Schl?ssel. Vision Sensoren werden f?r spezifische Applikationen gestaltet. Wenn es in dieser Applikation ein physikalisches Ph?nomen gibt, dann muss der Vision Sensor entsprechende Hilfestellung leisten, dieses Problem in den Griff zu bekommen. Wenn man die Randbedingungen dieser Applikationen kennt, kann man dem Anwender helfen, das Richtige zu tun und braucht keinen Spezialisten.

A.Behrens: Es gibt zwei Trends: Der eine sind Smartphone-Apps, also ein kleines St?ckchen Programmcode, was wir bedenkenlos ?ffnen, ohne dass wir Angst davor haben es zu benutzen. Wenn ich so eine App f?r den Bediener und eine weitere f?r denjenigen, der die Maschine einrichtet, h?tte, w?ren wir ein ganzes St?ck weiter. Das zweite, was uns hilft, ist, dass die Bedienoberfl?che mittlerweile dank Webtechnologie irgendwo sein kann und nicht zwangsweise auf dem Ger?t.

Ist Deep Learning eine Technologie, die auch auf einem Vision Sensor laufen k?nnte?

P.Keppler: Lernf?hige Algorithmen gibt es schon seit vielen Jahren und werden auch erfolgreich eingesetzt. Man braucht allerdings auch die richtigen Musterbilder, um das antrainieren zu k?nnen. Allerdings muss jemand auch festlegen, das ist gut und das schlecht. Wenn die Klassifizierung nicht funktioniert (= der Ausschluss zu gro? wird), dann r?cht es sich, wenn man vorher den Algorithmus nicht sauber trainiert hat. Bei einer klassischen Bildverarbeitung kann man dann immer noch ?den Regler verstellen, damit es wieder passt. Diese Algorithmen funktionieren, brauchen aber das entsprechende Expertenwissen zur Applikation und Algorithmik. Das Zusammenzuf?hren in eine reine Point&Click Software f?r einen Vision Sensor ist eine Herausforderung an das User Interface.

O.Munkelt: Heutzutage haben Vision Sensoren h?ufig eine ARM-Architektur, d.h. dort l?uft Linux und die normale Toolchain darauf. Sie k?nnen Ihre Algorithmik implementieren und wenn der Vision Sensor zuk?nftig statt derzeit 1GHz dann 5GHz hat und statt acht Cores 64 zur Verf?gung stellt und das auch noch bei 3,5W Leistungsaufnahme, k?nnen Sie auch andere Verfahren auf einen Vision Sensor bringen. Ich m?chte meine Hand nicht daf?r ins Feuer legen, wie die Welt in zehn Jahren aussieht, es ist aber durchaus m?glich, dass wir dann eine Leistungsf?higkeit haben, die einem heutigen PC entspricht.

P.Keppler: Wenn wir uns bei den Chipherstellern umschauen, was es heutzutage an SoC-Varianten (System-on-Chip) gibt in Kombination mit Boards auf denen Datenprozessoren zum Rechnen drauf sind, dann ist diese Technologie bereits da. Sie ist noch nicht im Vision Sensor gelandet, aber was ist denn ein Vision Sensor? Das kann auch eine klassische nicht-intelligente Kameras sein, eine kleine Platine mit einem SoC und allen Schnittstellen drauf, die sie ben?tigen, und pl?tzlich r?ckt die klassische Bildverarbeitung mit ihren komplexen Algorithmen ganz nah ran an Vision Sensoren, ?ber die wir gerade sprechen.

M.Gonschior: Wenn ich in meine Tasche fasse, habe ich mit meinem Smartphone bereits eine Art Vision Sensor. Smartphones benutzen den gleichen ARM-Prozessor, den wir auch in unseren Vision Sensoren nutzen. Die Technologieentwicklung im Consumerbereich treibt die M?glichkeiten der Vision Sensoren st?ndig voran. Mein Telefon liest beispielsweise QR-Codes oder erkennt bereits Gesichter, auch das ist Bildverarbeitung.

M.Reiter-Wassmann: Um nochmal auf das Beispiel zur?ckzukommen, bei dem der Vision Sensor entscheidet, was gut und was schlecht ist. Viele Anwender wollen verstehen, was ihr Ger?t macht. Allerdings ist die Nachvollziehbarkeit bei Deep Learning schwierig. Im Zuge einer Smart-Factory-Potenzialanalyse für ihren Kunden KSB identifizierte die Managementberatung NEONEX Opti mierungschancen bei der Beschaffung der Lieferantendokumentation sowie der Erstellung von Unterlagen zur Qualitätsprüfung entlang der Supply-Chain. ‣ weiterlesen

Signifikante Ressourceneinsparung bei Pumpenhersteller KSB

NEONEX, Fabasoft Approve & KSB: „Win-win-win-Situation“ durch starke Partnerschaft

Signifikante Ressourceneinsparung bei Pumpenhersteller KSB

O.Munkelt: Wenn Sie die Strecke von A nach B messen, wissen Sie, es sind 3cm. Das betrifft alle Technologien, die diese Transparenz und Nachvollziehbarkeit haben. Aber es gibt Technologien, die das nicht haben, wie alle Klassifikationstechnologien oder auch Deep Learning. Dort haben Sie ein Eingabebild, und der Computer erkl?rt, was er?sieht, beispielsweise ein Glas oder eine Flasche. Dann versuchen Sie das zu klassifizieren, aber was innendrin passiert, wissen Sie nicht.

M.Gonschior: Dieses Nachvollziehen hat wieder etwas mit UX-Design zu tun. Habe ich eine vern?nftige Usability, stellt niemand eine Technologie in Frage. Mit meinem Telefon kann ich Visitenkarten scannen und einlesen, d.h. wenn die Aufgabe gel?st wird, und das Ergebnis stimmt, ist unwichtig, was innen passiert.

M.Reiter-Wassmann: Die Frage der Nachvollziehbarkeit kommt typischerweise dann auf, wenn es halt nicht funktioniert. Wenn beim Handy die Visitenkarte nicht sauber gelesen wird, dann probiert man es solange bis es funktioniert. In der Industrie gibt es aber meistens nur eine einzige M?glichkeit zum Klassifizieren. Wenn diese nicht funktioniert, dann fragt sich der Anwender schon, warum es nicht geklappt hat.

Wie k?nnte ein Vision Sensor in vier Jahren aussehen?

P.Keppler: Der Vision Sensor der Zukunft muss optimal auf die jeweilige Applikation abgestimmt sein, d.h. der Anwender muss eine unabh?ngige Beratung bekommen, welcher Sensor f?r ihn der Richtige ist.

A.Behrens: Gerade im Bereich der Sensorik gibt es sehr dynamische Entwicklungen, z.B. durch das autonome Fahren. Mittlerweile werden Anwendungen nicht nur durch 2D/3D-Systeme gel?st, sondern auch mittels Lidar. Die Erfassung von 3D-Punktewolken hat einen ganz anderen Kontext bekommen, und wird Applikationen erm?glichen, die heute noch gar nicht absehbar sind.

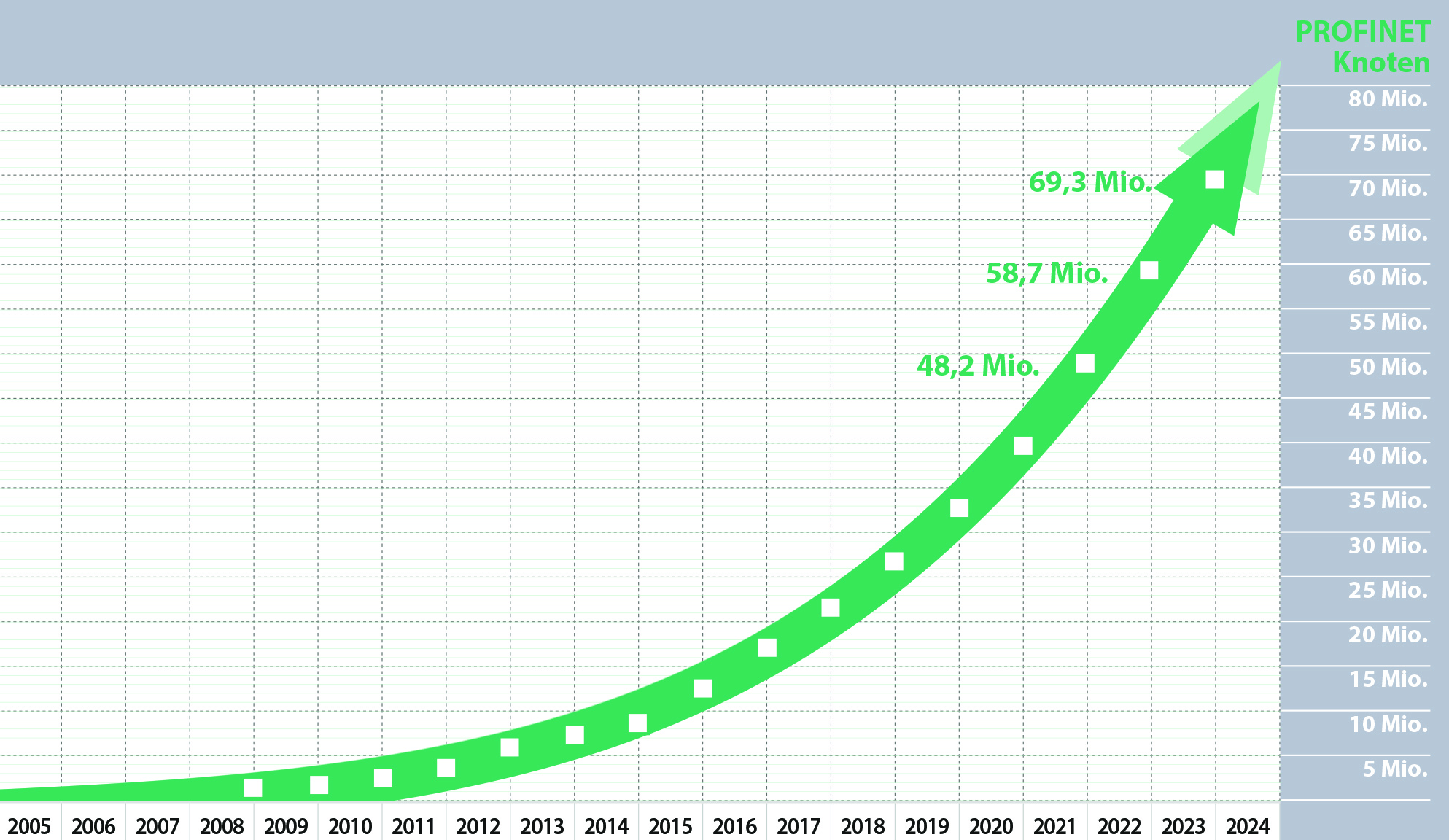

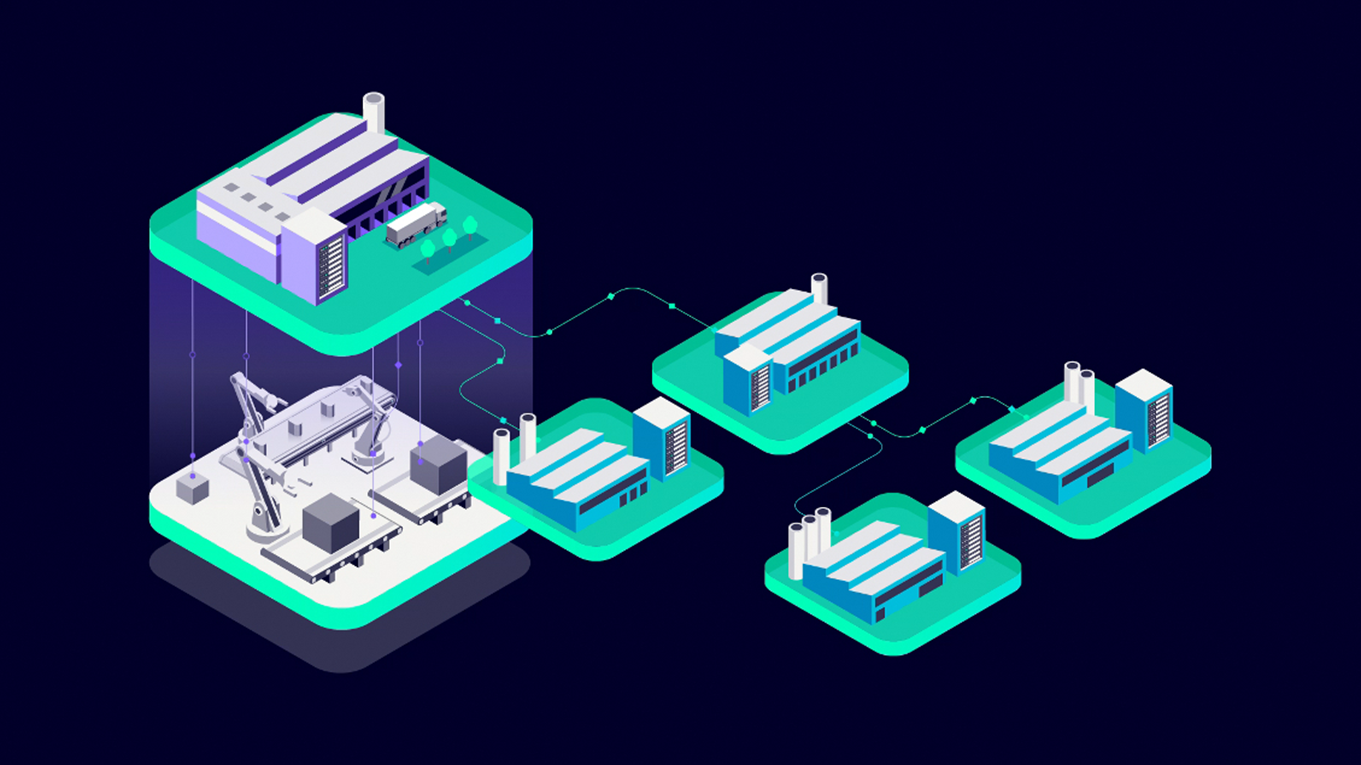

M.Reiter-Wassmann: Insgesamt wird die Leistungsf?higkeit der Ger?te weiter zunehmen. Am Ende braucht es aber einen guten Kompromiss aus Kosten und Flexibilit?t, damit auch die entsprechende Marktbreite erreicht wird. Zudem muss ein Vision Sensor auch Kommunikationsstandards wie Profinet oder OPC UA integriert haben.

M.Gonschior: Ich w?rde soweit gehen zu sagen, dass der Vision Sensor selbst mit Hilfe seines User Interface den Kunden so beraten muss, dass dieser seine Applikationen sicher l?sen kann.

Technologies, Baumer GmbH

Mike Gonschior, Produktmanager Objekterkennung,

Kamerasysteme & PMD, ifm electronic

Dr. Olaf Munkelt, CEO, MVTec Software

Andreas Behrens, Head of Marketing&Sales

Barcode-RFID-Vision, Sick AG

Peter Keppler, Director of Corporate Sales,

Stemmer Imaging