In vielen Industriebereichen steigt die Produktvarianz, was bedeutet, dass produzierende Unternehmen auch bei kleineren Losgrößen weiterhin effizient sein müssen. Besonders für kleine und mittelständische Firmen steigen die Herausforderungen dabei effizient und automatisiert produzieren zu können. Zudem sind kleine Unternehmen oftmals Teil einer größeren Wertschöpfungskette. Sie müssen dadurch schnell und unter hoher Termintreue reagieren können und ihr Produktionssystem auf eine neue Variante umstellen können. Problematisch ist zumeist nicht die Automatisierung von Produktionsprozessen an sich, sondern diese möglichst effizient zu erreichen. Besonders wichtig für kleine Losgrößen ist es, den Aufwand des Engineerings für alle an der Automatisierung beteiligten Systeme gering zu halten. Dabei hilft der zunehmende Trend zum Software-Defined-Manufacturing. Funktionen, die früher spezielle Hardware benötigten, werden zunehmend auf die Softwareseite der Automatisierung verlagert. Ein wichtiges Werkzeug für der Softwareentwickler im Bereich Produktionstechnik ist deshalb die virtuelle Inbetriebnahme (VIBN) mit ihren Simulationsmodellen.

Erleichterung für Entwickler

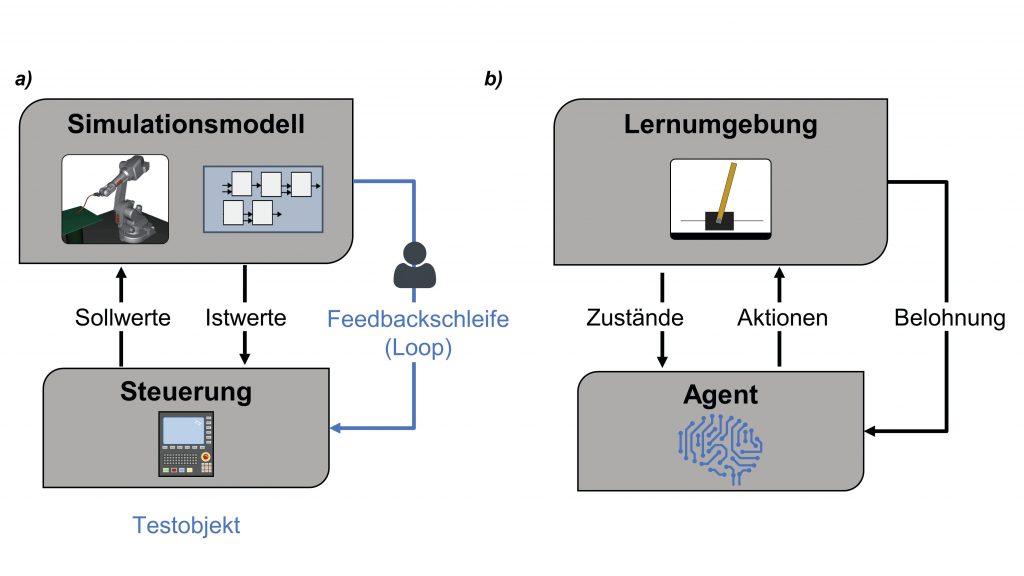

Die Simulationsmodelle stehen früher zur Verfügung als ein realer Aufbau des Produktionssystems, der beim Kunden oder auf eigenen Flächen in Betrieb genommen wird. Die Steuerungsentwicklung kann zeitlich und räumlich verlagert werden, was die Arbeit des Entwicklers erleichtert. Durch das simulierte System erhält er früher eine Entwicklungs- und Testumgebung. Eine solche Umgebung wird als X-in-the-Loop-System bezeichnet, in der ein Testobjekt X (das Steuerungssystem), mithilfe einer Feedback-Schleife iterativ entwickelt und verbessert werden kann. Das iterative Vorgehen wird durch den Entwickler vorangetrieben, der durch direktes Austesten eines Entwicklungsschritts Feedback erhält und darauf basierend den nächsten Schritt plant und umsetzt. Das iterative Vorgehen bei der Entwicklung am X-in-the-Loop-System unterscheidet sich im Grundsatz jedoch kaum von einer konventionellen Entwicklung ohne Simulationsmodelle. Egal ob das Feedback nun aus der Simulation oder noch vom realen System kommt, die Iterationen hin zur passenden Steuerungslösung sind nach wie vor vom Entwickler manuell durchzuführen. Ein Ansatz welcher die Iterationen mithilfe der Simulation selbstständig durchführt und so automatisiert zur Lösung kommt, wäre eine deutliche Erleichterung für den Entwickler und kann dadurch die Effizienz des Engineerings erheblich steigern. Im Zuge einer Smart-Factory-Potenzialanalyse für ihren Kunden KSB identifizierte die Managementberatung NEONEX Opti mierungschancen bei der Beschaffung der Lieferantendokumentation sowie der Erstellung von Unterlagen zur Qualitätsprüfung entlang der Supply-Chain. ‣ weiterlesen

Signifikante Ressourceneinsparung bei Pumpenhersteller KSB

NEONEX, Fabasoft Approve & KSB: „Win-win-win-Situation“ durch starke Partnerschaft

Signifikante Ressourceneinsparung bei Pumpenhersteller KSB

Reinforcement Learning als Ansatz

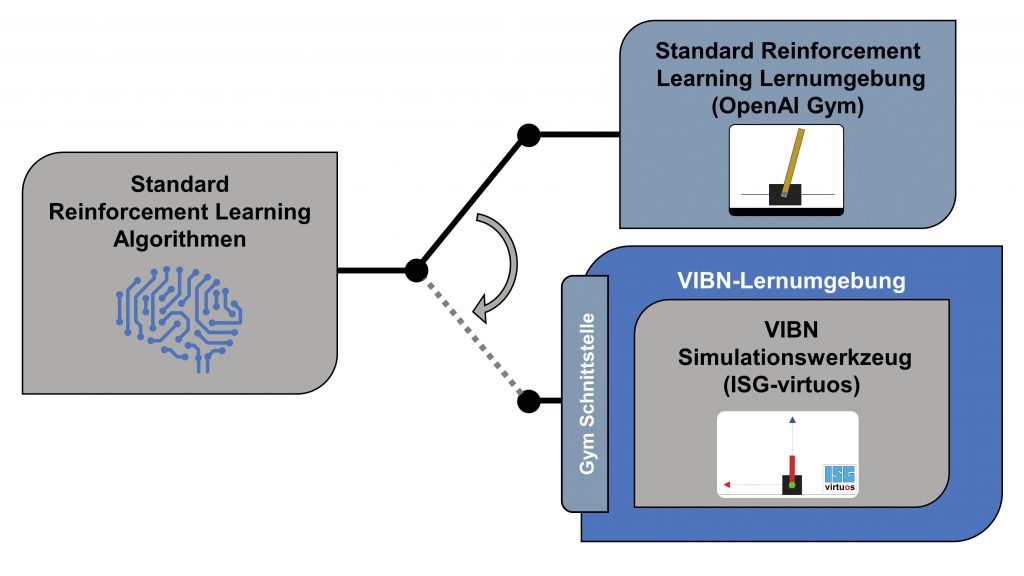

Eine solcher Ansatz zur selbständigen Iteration und Lösungsfindung am X-in-the-Loop-System ist Reinforcement Learning. Dieser Begriff steht für eine Klasse von Problemen, für die eine Vielzahl von Methoden im Bereich des maschinellem Lernens zur Verfügung stehen. Dabei interagiert ein lernfähiges Programm, ein sogenannter Agent mit einer bekannten oder unbekannten Umgebung (engl. Environment). Der Agent sieht die Umgebung über bestimmte Zustandsvariablen und kann über definierte Aktionen Einfluss auf seine Umgebung ausüben. Er lernt dabei laufend dazu und passt sich an, indem er für jede Iteration eine Belohnung oder Bestrafung als numerischem Feedback von der Umgebung erhält. Das Ziel des Agenten ist es die Belohnung auf lange Sicht zu maximieren. Reinforcement Learning hat in vielen, oftmals noch nicht-kommerziellen, Bereichen beeindruckende Ergebnisse erzielt. Bekannte Beispiele sind Videospiele, oder Simulationen von Brettspielen wie Schach oder Go als Lernumgebung, in denen Agenten, über die einfache Maximierung eines Punktestands, auch die fähigsten Menschen weit übertreffen konnten. Entscheidend für Reinforcement Learning ist die Lernumgebung innerhalb derer der Agent interagieren kann. Für Produktionssysteme scheidet das reale System aus, da der Agent während des Lernens unweigerlich Fehler machen muss. Diese Fehler wären kostenintensiv und teilweise gefährlich für das Produktionssystem. Daher müssen simulierte Lernumgebungen geschaffen werden, oder noch besser, bereits bestehende Simulationsumgebungen müssen so erweitert werden, dass sie den Anforderungen des Reinforcement Learning gerecht werden.

Testumgebung als Lernumgebung

Der vorgestellte Lösungsansatz basiert auf der strukturellen Ähnlichkeit zwischen der X-in-the-Loop-Simulation und Reinforcement Learning. Die Idee besteht darin, die Entwicklungs- und Testumgebung so zu erweitern, dass sie vom Funktionsumfang einer Lernumgebung entsprechen kann. Der Agent agiert als Steuerungssystem in der X-in-the-Loop-Struktur. Ziel ist es die Abläufe und damit die Programmierung der Steuerung zu erlernen und diese anschließend auf das Steuerungssystem zu übertragen. Die Kommunikation der Soll/Ist-Werte zwischen den simulierten Komponenten und der Steuerung muss in die für Reinforcement Learning übliche Struktur mit Zuständen und Aktionen eingepasst werden. Als Ergänzung zu der X-in-the-Loop Struktur muss eine spezifische Belohnungsfunktion integriert werden, um das Reinforcement Learning Problem vollständig zu definieren. Die Belohnungsfunktion muss dabei als Zielstellung vom Steuerungsentwickler vorgegeben werden. Der Agent ist dadurch in der Lage selbstständig, in seinem über die Aktionen definierten Lösungsraum, iterativ eine Strategie zu finden, um den in der Lernumgebung vorgegebenen Anwendungsfall optimal zu lösen.